Быстрый анализ сайта

- Stats: 1525 1

- Author: admin

- Category: SEO, Просування сайту. Копірайт, Статті

- Comments: Комментариев нет

Материал подготовлен на основе выступления Дмитрия Бондаря (Boosta) на конференции NaZapad

Почему сайту может быть плохо? 55% причин роста или проседания довольно просты: структура сайта (как он физически сделан), контент и ссылки. Большая часть успеха/неуспеха сайта зависит только от этого.

Если кому-то интересно, на что приходится еще 45% возможных причин, влияющим на успех сайта, то им лучше обратиться вот к этим трем гражданам, которые на регулярной основе отнимают деньги у честных оптимизаторов:

Как они это делают? Меняют поисковые алгоритмы, выдумывают новые пессимизирующие фильтры и т.д. Поэтому в некоторых случаях с сайтом совершенно ничего нельзя сделать, даже если он сам отличный, содержит полезный контент и хорошие ссылки.

Рассмотрим методы анализа подвластных вебмастеру 55%.

Индекс

Первое, что нужно проанализировать, это присутствие сайта в индексе ПС. Для этого используется оператор site:. Вбитое в поисковую строку [site: ваш сайт] — это то, с чего начинают анализ сайта все seo-специалисты.

На что необходимо обращать в внимание в полученной по такому запросу выдаче:

- Главная страница сайта должна быть на первом месте. Если это не так, то у сайта большие проблемы — вероятней всего он глубоко под каким-то фильтром ПС.

- Количество страниц сайта, проиндексированных поисковой системой, должно соответствовать их реальному количеству. Если анализируем свой сайт, то мы примерно знаем, сколько у нас создано страниц — важно, чтобы это число не слишком отличалось от результатов, выдаваемых поисковой системой, ни в ту ни в другую сторону.

- Правильный порядок лендингов в выдаче. Самые важные страницы сайта должны идти сразу после главной — это, как правило разделы, страницы листинга товаров, блог компании и т.д. Если что-то, что никак не продвигается, показывается на 3-4 месте после главной страницы — это сигнализирует о том, что с сайтом что-то не так.

- Даты обновления страниц должны быть свежими. Если это не так, то это также является свидетельством неблагополучия сайта.

- Сниппеты должны быть без переспама. В принципе, осмысленные сниппеты являются показателем того, что над сайтом работают. Если в сниппетах отображается какая-то ерунда, это значит, что description не заполнен и поисковая система сама подтягивает в сниппеты, что ей под руку попадется.

Далее в поисковой строке к оператору site: необходимо добавить www для того, чтобы проверить в индексе наличие мусорных страниц, которые могут туда попасть случайно, после какой-либо работы над сайтом. Все найденные страницы должны быть закрыты от поисковых систем в robots.txt.

После этого желательно зайти в поиск при помощи VPN и еще раз посмотреть на сайт. Таким образом можно увидеть результаты поиска без персонализации — а именно то, что видит в поиске интернет-пользователь, который не ходит на этот ресурс каждый день.

Также очень полезно посмотреть на свой сайт нелюбимым браузером (не тем, который постоянно используете), таким образом иногда можно обнаружить очень «интересные» вещи, над которыми также нужно поработать и устранить.

Траст

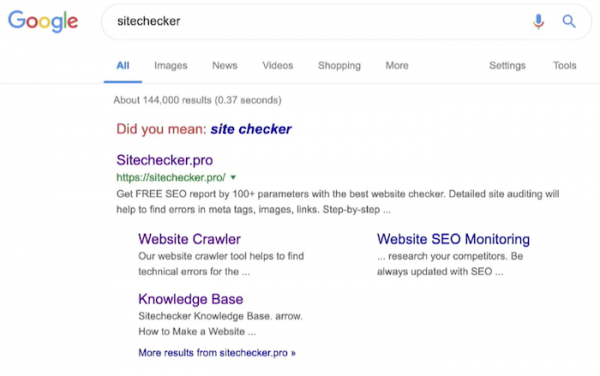

Траст сайта — понятие довольно относительное. Нигде точно не описано его влияние на позиции сайта, однако, все seo-специалисты знают, что трастовость ресурса очень важна. Оценить траст сайта, не прибегая ни к каким специальным инструментам можно, введя в поисковую строку его название без указания доменной зоны (или просто ввести в поисковую строку название своего бренда).

Здесь важно обращать внимание на все. Если при вводе имени сайта или бренда ПС предлагает выбрать что-то другое (с исправленной буквой, пробелом и т.д) — это сигнал о том, что трастовость ресурса оставляет желать лучшего. Значит, его в поиске ищет не так много людей и ПС не осведомлена о том, что существует продукт, который называется именно так.

Безусловно, на первом месте выдачи по такому запросу должен идти искомый сайт. Если это не так, то это говорит о низком трасте ресурса, и с этим обязательно нужно поработать.

Далее вводим в поисковую строку имя сайта вместе с доменом. Искомый сайт должен оставаться в выдаче первым по этому запросу. Также стоит обратить пристальное внимание на сниппет — по неофициальным данным, чем он осмысленней и длиннее, тем выше траст анализируемого ресурса.

Проскроллив результаты выдачи, стоит обратить внимание на те ресурсы, которые появляются в выдаче сразу после результатов, содержащих название искомого сайта. Таким образом можно обнаружить не только ворованный с сайта контент, но и конкурентов, которые таргетятся под искомый домен или бренд-нейм. Таким образом тоже можно оценить траст сайта — если он слабенький, то страницы более трастовых конкурентов могут отображаться в поиске уже начиная с 3-4 позиции.

Нормальным для сайта является занятие первых 10 строк в поисковой выдаче по этому запросу. На всякий случай стоит заглянуть и в robots.txt анализируемого сайта, чтобы оценить объем закрытых от поиска страниц.

Нелишне также будет проверить сайт на контент запрещенных тематик. Для этого используются запросы следующего типа — [site:домен viagra], [site:домен porno], [site:домен casino online] и проч. Это делается по причине того, что не всегда можно увидеть глазами то, что содержится в коде сайта, а поисковые системы это видят и могут учитывать.

Выводы:

Если по запросу, содержащему название сайта, на первом месте не отображается главная страница, это практически на 100% фильтр. Здесь может быть только один выход — делать новый сайт.

Если было обнаружено несовпадение страниц в индексе ПС с их реальным количеством, то скорее всего у сайта проблемы со структурой (она либо неверно сделана, либо криво сверстана), со вложенностью страниц, с их индексацией (ошибки вебмастера), или с контентом (не очень релевантный, не нравится ПС).

Если наблюдается неверный порядок отображения лендингов после главной страницы, то здесь также следует винить оптимизатора, потому что именно он накачивает весом определенные страницы, а также стоит подробней проанализировать структуру кода.

Если даты обновления страниц не свежие, то скорее всего у сайта либо низкий траст, либо очень большой размер самого сайта, либо очень плохой контент низкого качества.

Фильтры

Быстро определить наличие фильтров Google на своем сайте можно, воспользовавшись специальными сервисами, например, сервисом от Barracuda, который отлично и очень точно определяет наличие санкций ПС. Там можно посмотреть все апдейты поискового алгоритма Google и точно определить, после какого из них началось падение (если началось).

Рекомендуется проверить свой сайт через этот сервис даже в том случае, если нет особенного проседания трафика и не предполагается наличие каких-то фильтров. Зачастую эти фильтры могут быть в наличии, и даже если они не сказываются никак на позициях сайта, они совершенно точно могут замедлять и даже останавливать его дальнейший рост.

Для анализа клиентского сайта можно использовать даты апдейтов, которые есть в сервисе Barracuda (где рекомендуется зарегистрировать свой сайт), а затем при помощи сервисов Semrush или Ahrefs посмотреть графики позиций искомого сайта и таким образом определить, после какого из апдейтов началось падение.

Работа над сайтом

Проанализировать сайт на предмет того, насколько им занимаются/занимались специалисты, можно при помощи быстрого и условно бесплатного (5 отчетов) инструмента Builtwith. Этот сервис определяет имеющийся на сайте технических софт:

Если на сайте можно увидеть более одной системы аналитики, a/b-тесты, продвинутые плагины, то можно сделать вывод о том, что над сайтом работают, и команда им занимается. Таким образом можно отслеживать и своих конкурентов, чтобы понять, каков их общий подход к работе над сайтом.

Контент

Для быстрого анализа контента сайта есть множество удобных инструментов. В первую очередь можно рекомендовать Siteliner, который сканирует сайт (250 страниц бесплатно) и выдает количество имеющихся дублей страниц, вес страниц и количество слов.

Кроме того, инструмент показывает количество сквозных блоков (match pages), дублирующихся на большом количестве страниц — это различные меню, отзывы, одинаковые блоки контента. При первом взгляде это может быть незаметно, если удачно встроено в дизайн сайта, однако, робот воспринимает совсем по-другому и, скорее всего, определяет, что на таких страницах полезного и уникального контента недостаточно.

Проанализировав вес страниц (page power) сайта, нужно убедиться, что все важные лендинги получают наибольший вес. Если это не так, то делаем вывод, что на них ведет недостаточное количество ссылок и над этим нужно поработать.

Проверить наличие дублей с точки зрения ключевых слов можно при помощи все того же оператора site:, задав в поисковой строке запрос [site:домен ключ]. Таким образом можно оценить, какие страницы, продвигающиеся по ключевым запросам, имеют больший вес, и над какими из них, возможно, нужно поработать. Таким же образом можно проанализировать тайтлы и вхождения ключей.

Резюмируя, можно сказать, что внутренний плагиат редко является причиной каких-то серьезных проблем сайта. Исключение составляют только многостраничники — сайты с более чем 200 тыс. страниц — в этом случае дублирование может являться большой проблемой.

Основной целью контентного анализа является определение веса значимых для сайта страниц и разработка стратегии по их продвижению.

Структура страницы

В современном мире страницу сайта можно оценить легко и просто, посмотрев на нее глазами пользователя с экрана мобильного устройства. Если пользователю легко ориентироваться на странице и решить свою задачу, значит, со страницей все в порядке. Если же возникают какие-то трудности — это повод для того, чтобы заняться ее улучшением.

Важно помнить, что страница сайта должны выглядеть адекватно, как с точки зрения пользователя с мобильным телефоном, так и с точки зрения поискового робота. Поэтому обращаем внимание на имеющиеся редиректы, на заголовки, тайтлы и % вхождения ключей.

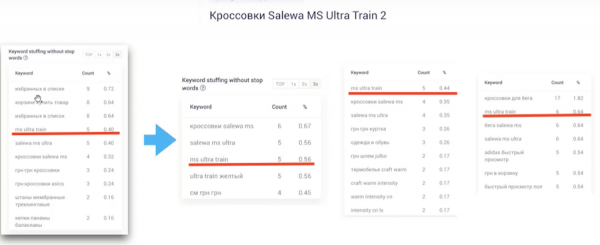

В приведенном ниже примере можно увидеть, как у вроде бы адекватной во всех отношениях страницы, содержащееся в название наименование товара находится отнюдь не на первом месте и с небольшим процентом вхождения:

Для сравнения, если посмотреть таким же образом страницы всех конкурентов этой страницы по запросу в выдаче Google, можно увидеть следующее:

Это все выливается в то, что несмотря на возраст и трастовость магазина, эта страница в глазах поисковой системы проигрывает конкурентам. Поэтому не забываем смотреть на страницы сайта глазами робота через Google Search Console, либо, если такой возможности нет, — через кэш поисковой системы (текстовая версия страницы). Текст, относящийся к товару или услуге, которые представлены на странице, должен находиться как можно ближе к началу, а не в самом низу, после корзины, списков, меню и проч.

Ссылки

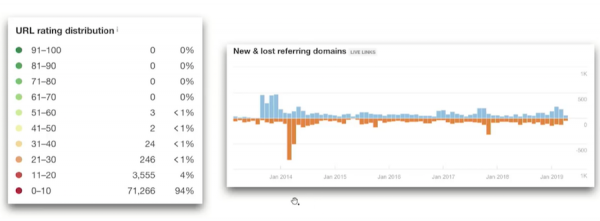

К сожалению, быстро проанализировать ссылочную массу не получится. Это требует довольно много времени и применения специальных инструментов. Тем не менее, общее представление о ссылках на сайте можно получить, посмотрев анкор-лист (одной страницы / всего сайта).

На что обращать внимание:

- анкор-лист должен быть природным для ниши / региона / языка

- сбалансированным по каждой важной странице

- релевантным, кэп!

Быстро проанализировать качество ссылок можно при помощи того же Ahrefs, по следующим графикам:

Результаты проделанной работы с сайтом желательно собрать в некое подобие чек-листа, чтобы в дальнейшем с ним было удобно работать. Также необходимо замерить все показатели, которые желательно поменять (индекс, видимость и т.д.) и приступать к работе над сайтом. Практика показывает, что подход — изменить что-то одно и посмотреть на результаты — работает значительно хуже, чем — исправлять сразу все косяки и одновременно вносить улучшения, а потом уже смотреть на общий результат.

Отправить ответ